En se fiant à l’imagination des scénaristes d’Hollywood on

jurerait que la généralisation des logiciels et machines intelligents est le

pire des périls menaçant la planète. On peut pourtant facilement arguer que les

intelligences artificielles soulèvent une problématique bien plus vaste et

subtile que se demander si elles représentent un écueil pour notre monde

La sortie de la première saison de “Westworld”, la nouvelle série événement

de la chaîne HBO qui avait déjà produit Games of Thrones, a relancé le débat

autour de l’intelligence artificielle. Cette série, créée par Jonathan Nolan et

Lisa Joy, inspirée du film du même nom de 1973, nous plonge dans un parc

d’attraction futuriste, recréant l'atmosphère du Far West grâce à des robots

extrêmement réalistes. Ces humanoïdes, marchent, parlent, interagissent les uns

avec les autres, et sont même capables d’empathie et de sentiments. Ils

semblent ainsi plus réels qu’il n’est possible de l’imaginer. Si ce scénario

est clairement une fiction, quelles sont les avancées scientifiques dans le

domaine de l’intelligence artificielle ? Sommes-nous proches d’atteindre la

perfection des machines de Westworld ? Et surtout, faut-il avoir peur de ces

progrès ?

Mettons tout de suite les choses au point : non, l’intelligence

artificielle ne présente pas un danger pour l’humanité et il faut laisser aux

scénaristes de « Terminator » la vision d’un super-ordinateur qui

déciderait d’éliminer la race humaine. Ce n’est pas parce que vous parlez avec

Siri que vos jours sont comptés. Les technologies d’intelligence artificielle

connaissent bel et bien des progrès concrets et elles sont déjà omniprésentes

autour de nous mais sans présenter de menaces dans un avenir proche.

On aurait tendance à l’oublier, mais il n’existe pas une

« intelligence artificielle » et l’expression désigne avant tout la

discipline scientifique, aux questionnements hétéroclites, et non pas une

entité unique et polyvalente. En vérité, il s’agit plutôt de logiciels,

machines et robots conçus dans des buts - et donc ayant des designs et des

habilités - très différents. Apprentissage automatisé, recognition visuelle,

reconnaissance de la parole ou traduction automatique forment autant de

domaines de recherche bien distincts, plus ou moins avancés. Par exemple, le robot Curiosity, conçu pour récolter

et analyser des échantillons du sol martien après reconnaissance visuelle, pèse

900 kilogrammes pour une longueur de 2.7 mètres, tandis que le robot ApriPetit,

qui a été imaginé pour aider et communiquer avec les personnes âgées, ne mesure

que 16 centimètres de haut. Il existe autant de robots que de tâches à

accomplir, et rares sont ceux qui manient la pluridisciplinarité avec

virtuosité. Il y a de quoi rassurer les inquiets, le pire que puisse faire une

IA de nos jours c’est d’envoyer ce SMS enflammé à votre mère alors qu’il était

destiné à votre nouvelle conquête, et nous sommes bien loin de la révolte des

machines qui a lieu dans I-Robot.

Malgré tout,

la généralisation de l’IA autour de nous peut provoquer un certain malaise.

Cela est lié au fait que nous leur préposons une part de nos capacités

typiquement humaines. Plus un automate nous ressemble, plus nous ressentons de

l’empathie pour lui.

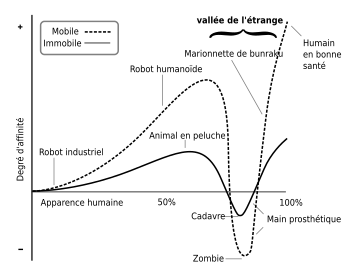

Il existe cependant un

degré de ressemblance à partir duquel la perception des détails révélant qu’il

ne s’agit pas d’un humain provoquerait un profond trouble. Le robot ne serait

plus jugé comme une machine se comportant comme un humain à quelques défauts

près, mais comme un humain se comportant de façon étrange. Cette théorie,

développée par le roboticien japonais Masahiro Mori, est appelée la théorie de

la vallée dérangeante.

Le scientifique utilise le terme de “vallée” car selon lui il ne s’agirait

que d’un cap à passer. Une fois la ressemblance proche de la perfection, les

humains seraient beaucoup plus à l’aise avec l’aspect mimétique d’une machine. Ainsi,

les logiciels et robots créés aujourd’hui sont encore bien loin de cette

“vallée dérangeante”, mais considérant les avancées faites en recherche,

notamment dans le domaine des machines moléculaires ou des calculateurs

quantiques, on peut facilement imaginer qu’ils atteindront très rapidement ce

stade.

Cependant, l’étude menée l’université de Stanford « ARTIFICIAL

INTELLIGENCE AND LIFE IN 2030 » récapitulant plus de cent ans de recherche en intelligence artificielle

donne une conclusion claire : il n’y a pas lieu de s’inquiéter dans

l’avenir immédiat. Finalement, la crainte que peuvent susciter les IA tient (presque

exclusivement) à leur niveau d’autonomie. La question n’est plus de décider si

nous acceptons d’être entourés de machines et de logiciels intelligents et

autonomes, mais de déterminer jusqu’à quel point nous souhaitons qu’ils le

soient. C’est pourquoi le panel de chercheurs précise également qu’il faudra

veiller à ce que le but de l’intelligence artificielle reste celui de créer de

la valeur pour nos sociétés. Il faudra pour cela, selon eux, améliorer

l’expertise des gouvernants, ne pas freiner la transparence et surtout financer

des études d’impact afin d'adapter dès aujourd'hui nos politiques

publiques à cette révolution en marche, estiment les experts de Stanford.

Loïcia Bluteau

Sources :

Aucun commentaire:

Enregistrer un commentaire